AI法チャンネル│日本一わかりやすい EU AI法・AI規制メディア

最終更新日:2025年6月17日

1. はじめに:なぜEU AI法を理解すべきか

1-1. EU AI法とは何か

EU AI法(正式名称:Regulation (EU) 2024/1689)は、人工知能システムの開発・提供・使用に関する世界初の包括的な法的枠組みです。2024年8月1日に発効したこの法律は、AIの信頼性と安全性を確保しながら、イノベーションを促進することを目的としています。

「Recital(前文)とArticle(条文)の違いは”解釈ガイドか、法的拘束力か”」──この基本構造を理解することが、EU AI法攻略の第一歩です。前文は法律の趣旨や背景を説明し、条文の解釈指針となります。一方、条文は法的拘束力を持ち、違反すれば制裁金の対象となります。

1-2. なぜ日本企業も対応が必要なのか

EU AI法は「ブリュッセル効果」と呼ばれる域外適用の仕組みを持っています。以下のいずれかに該当する場合、日本企業も規制対象となります:

- EU市場へのAIシステム提供: EU域内でAIシステムやその出力を提供する場合

- EU居住者へのサービス提供: 物理的な拠点の有無に関わらず、EU居住者を対象とする場合

- EU域内でのAI出力使用: AIシステムの出力がEU域内で使用される場合

さらに重要なのは、違反時の制裁金の大きさです。最高で全世界年間売上高の7%または3500万ユーロのいずれか高い方という、GDPR(最高4%)を上回る巨額の制裁金が科される可能性があります。

1-3. 本記事で得られる3つの価値

- 体系的理解: 180の前文と113の条文という膨大な内容を、構造的に整理して理解できます

- 実務的指針: リスク分類に基づく具体的な対応方法と優先順位が明確になります

- 時間短縮: 全文を読まずとも、30分で実務に必要な要点を把握できます

2. ドキュメント構造を数字で掴む

2-1. EU AI法の基本構成

EU AI法の文書は、一見すると膨大で複雑に見えますが、実は非常に体系的に構成されています。まず全体の「地図」を頭に入れることで、必要な情報に素早くアクセスできるようになります。

| 要件 | 条文 | 実装のポイント | 必要なリソース |

| リスク管理システム | 第9条 | ・PDCAサイクルの確立 ・リスクレジスタの作成 ・定期レビュープロセス | ・リスク管理ツール ・専門人材1-2名 |

| データガバナンス | 第10条 | ・データ品質基準の策定 ・バイアス検出手法確立 ・データセット文書化 | ・データ品質ツール ・データサイエンティスト |

| 技術文書 | 第11条 | ・Annex IVテンプレート活用 ・version管理システム ・更新プロセス確立 | ・文書管理システム ・テクニカルライター |

| 記録保持 | 第12条 | ・ログ設計と実装 ・保存期間管理 ・アクセス制御 | ・ログ管理基盤 ・ストレージ容量 |

| 透明性確保 | 第13条 | ・利用者向け説明文書 ・UIでの情報提供 ・多言語対応 | ・UXデザイナー ・翻訳リソース |

| 人間の監督 | 第14条 | ・Human-in-the-loop設計 ・緊急停止機能 ・監督者トレーニング | ・システム改修 ・教育プログラム |

| 精度・堅牢性 | 第15条 | ・性能指標の定義 ・敵対的テスト ・セキュリティ監査 | ・MLOpsツール |

前文(Recitals)の重要性

前文は単なる前書きではありません。欧州司法裁判所(CJEU)は、法律の解釈において前文を重要な参考資料として扱います。例えば、「AIシステム」の定義が不明確な場合、関連する前文を参照することで立法者の意図を理解できます。実務では、条文の要件が曖昧な場合に前文を確認することで、より適切な解釈が可能になります。

条文(Articles)の構造

113の条文は12のTitle(章)に分かれており、各Titleは特定のテーマを扱います。条文番号は連続していますが、内容は階層的に整理されているため、目的に応じて必要な部分だけを参照できます。例えば、生成AIについて知りたい場合は、Title V(第52a-55条)を重点的に読めば良いのです。

2-2. 12のTitles(章)の詳細解説

各Titleは独立したテーマを扱いながらも、相互に関連しています。以下、実務で特に重要なTitleを中心に解説します。

Title I – 一般規定(Art. 1-4)

この章は法律全体の基礎となる部分です。特に重要なのは第3条の定義規定で、「AIシステム」「提供者」「使用者」など、法律全体で使用される用語が定義されています。曖昧な用語の解釈で迷った際は、必ずここに立ち返ることが重要です。

Title II – 禁止されるAIプラクティス(Art. 5)

わずか1条ですが、最も重要な条文の一つです。8つの禁止事項が列挙されており、これらに該当するAIシステムは、例外なくEU域内での使用が禁止されます。多くの企業にとって、まず確認すべきはこの条文です。

Title III – ハイリスクAIシステム(Art. 6-51)

全体の約40%を占める最大のTitleです。ハイリスクAIに課される要件が詳細に規定されています:

- 第6-7条: ハイリスクAIの分類規則

- 第8-15条: 技術的要件(リスク管理、データガバナンス、技術文書等)

- 第16-29条: 関係者の義務(提供者、輸入者、販売者等)

- 第30-51条: 適合性評価と認証手続

Title IV – 特定のAIシステムに対する透明性義務(Art. 52)

チャットボットやディープフェイクなど、人間との相互作用を伴うAIシステムに対する透明性要件を規定しています。「AIと対話していることを利用者に明示する」という基本的な要件から始まり、感情認識システムや生体分類システムへの特別な配慮まで含まれています。

Title V – 汎用AIモデル(Art. 52a-55)

2023年の最終交渉で追加された、生成AIを含む汎用モデルに関する規定です。ChatGPTやStable Diffusionのような基盤モデルの提供者に対して、透明性確保や著作権配慮などの義務を課しています。

Title VI – イノベーション支援措置(Art. 56-60)

規制一辺倒ではなく、イノベーションを促進するための措置も含まれています。AIサンドボックス(規制の実験場)の設置や、中小企業への配慮などが規定されています。

Title VII – ガバナンス(Art. 61-67)

EU全体および各加盟国レベルでの執行体制を規定しています。EU AI Officeの設置や、各国監督当局の役割などが明確化されています。

Title VIII – EU AIデータベース(Art. 68-71)

ハイリスクAIシステムの登録データベースに関する規定です。透明性確保と市場監視を目的として、公開データベースへの登録が義務付けられています。

Title IX – 市場後監視・情報共有・市場監督(Art. 72-91)

AIシステムの市場投入後の継続的な監視体制について規定しています。インシデント報告義務や、当局による市場監督権限などが含まれます。

Title X – 行動規範及び自主的認証(Art. 92-93)

法的義務ではない自主的な取り組みを奨励する規定です。業界団体による行動規範の策定や、任意の認証制度などが想定されています。

Title XI – 最終規定(Art. 94-101)

既存のEU法との関係や、法律の見直し規定などが含まれています。特に第94条のGDPRとの関係は、プライバシー保護の観点から重要です。

Title XII – 制裁金(Art. 102-113)

違反に対する制裁金の額や、その決定要因などを規定しています。最高で全世界年間売上高の7%という巨額の制裁金は、この章に根拠を持ちます。

2-3. Annexes(付属書)の実務活用法

11の付属書は、いわば「実務マニュアル」の役割を果たします。条文で定められた要件を具体的にどう実現するか、その詳細が記載されています。

特に重要な4つのAnnex

Annex III – ハイリスクAIシステムのリスト 8つのカテゴリーに分けて、ハイリスクと見なされるAIシステムの具体例が列挙されています。自社のAIシステムがハイリスクに該当するかを判断する際の「チェックリスト」として使用します。例えば:

- 自然人の生体認証・分類

- 重要インフラの安全管理

- 教育機関での評価・入学判定

- 採用・人事評価での使用

- 信用評価・保険査定

- 法執行での使用

Annex IV – 技術文書 ハイリスクAIシステムに必要な技術文書の記載事項が詳細に規定されています。以下の要素を含む必要があります:

- AIシステムの一般的説明

- 開発プロセスの詳細

- データの取得・処理方法

- アルゴリズムの設計仕様

- リスク管理措置

- 性能指標と試験結果

- 市場後の監視計画

Annex VII – 品質管理システムの評価を伴う適合性評価 第三者認証が必要な場合の詳細な手順が記載されています。ISO 9001のような品質管理システムの要素と、AI特有の要件が組み合わされています。

Annex XI – システム性リスクを有する汎用AIモデル評価の技術文書 計算能力が10^25 FLOPs以上の大規模モデルに要求される追加文書の内容です。モデルの能力評価、リスク評価、軽減措置などを含みます。

Annexの効果的な使い方

- テンプレートとして活用: 特にAnnex IVやAnnex XIは、そのまま文書のテンプレートとして使用できます

- チェックリストとして活用: 要件の抜け漏れを防ぐため、Annexの項目をチェックリスト化します

- 監査基準として活用: 内部監査や外部認証の際の評価基準として使用します

3. 規制のフレームワーク

3-1. リスクベースアプローチの本質

EU AI法の最大の特徴は「リスクベースアプローチ」です。これは、AIシステムが人間の健康、安全、基本的権利に与えるリスクの大きさに応じて、規制の強度を変えるという考え方です。このアプローチにより、イノベーションを過度に阻害することなく、必要な保護を実現しています。

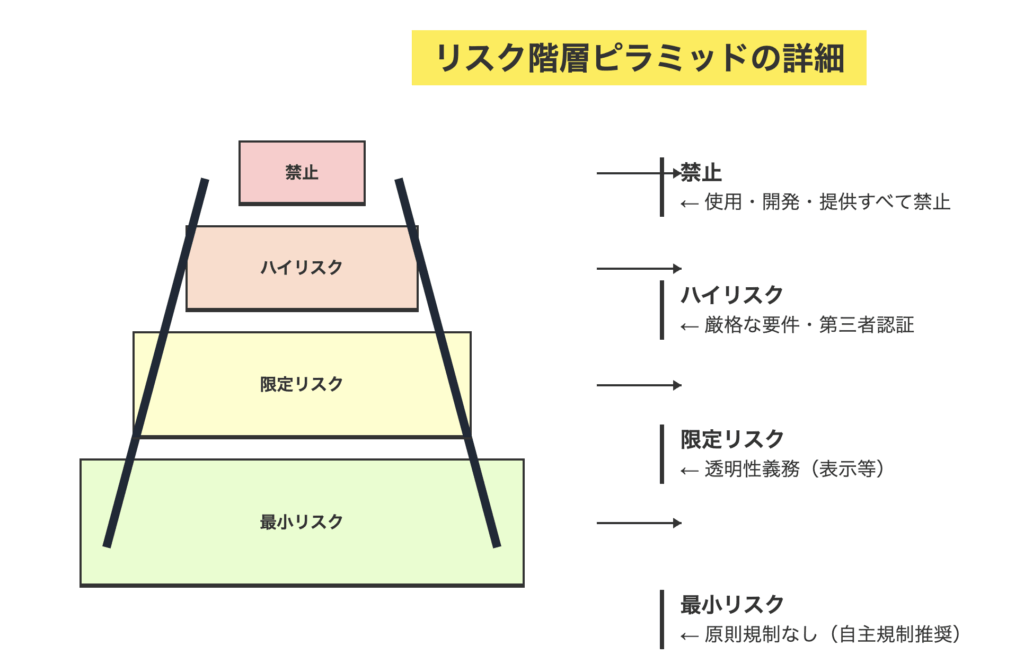

リスク階層ピラミッドの詳細

この階層は固定的なものではなく、AIシステムの使用方法や文脈によって変動する可能性があります。例えば、同じ顔認識技術でも、スマートフォンのロック解除(最小リスク)と、公共空間での個人特定(禁止AI)では、リスクレベルが全く異なります。

3-2. 各リスクカテゴリーの詳細解説

1. 禁止AI(Unacceptable Risk)- 第5条

禁止AIは「人間の尊厳を侵害し、基本的権利を脅かす」と判断されたAIシステムです。これらは例外なく禁止され、開発・提供・使用のすべてが違法となります。

8つの禁止カテゴリーの詳細

- サブリミナル技術による操作(第5条1項a)

- 人間が意識的に認識できない技術を使用して行動を操作

- 例:購買行動を無意識に誘導する超音波メッセージ

- 脆弱性の悪用(第5条1項b)

- 年齢、障害、社会的・経済的状況による脆弱性を悪用

- 例:認知症患者を標的にした詐欺的な金融商品の勧誘

- 社会的スコアリング(第5条1項c)

- 社会的行動に基づく包括的な評価システム

- 例:中国の社会信用システムのような仕組み

- 犯罪リスク評価(第5条1項d)

- 個人の特性のみに基づく犯罪予測

- 例:居住地域や民族性だけで犯罪傾向を予測

- 顔認識データベースの構築(第5条1項e)

- インターネットやCCTVからの無差別な顔画像収集

- 例:SNSから自動的に顔データを収集してDB化

- 職場・教育機関での感情認識(第5条1項f)

- 例外:医療・安全上の理由がある場合を除く

- 例:授業中の学生の表情から集中度を評価

- 生体分類システム(第5条1項g)

- 人種、政治的見解、性的指向等のセンシティブ属性の推定

- 例:顔写真から性的指向を推定するシステム

- リアルタイム遠隔生体認証(第5条1項h)

- 公共空間での法執行目的(厳格な例外あり)

- 例:街頭カメラでの一般市民の継続的な監視

例外規定の理解

リアルタイム遠隔生体認証については、以下の3つの条件すべてを満たす場合のみ例外的に許可されます:

- 特定の重大犯罪(テロ、誘拐等)の捜査

- 司法当局の事前承認

- 時間・場所・対象者の厳格な限定

2. ハイリスクAI(High Risk)- 第6-51条

ハイリスクAIは、適切な保護措置を講じれば使用可能ですが、厳格な要件を満たす必要があります。該当性は2つのルートで判断されます:

ルート1:製品安全規則との統合(第6条1項) 既存のEU製品安全規則(Annex II記載)の対象となる製品の安全コンポーネントとして使用されるAIシステム。例:

- 医療機器の診断支援AI

- 自動車の自動運転システム

- 産業用ロボットの制御AI

ルート2:特定用途リスト(第6条2項・Annex III) Annex IIIに列挙された8つの領域での使用:

- 生体認証・生体分類

- 個人の識別・認証・分類

- 要件:高い精度、バイアス対策、プライバシー保護

- 重要インフラ

- 道路交通、水道、電気、ガス等の管理・運用

- 要件:高い信頼性、フェイルセーフ機構、人間の監督

- 教育・職業訓練

- 入学・評価・試験監督での使用

- 要件:公平性、説明可能性、異議申立手続

- 雇用・労働者管理

- 採用、昇進、解雇、タスク配分での使用

- 要件:差別防止、透明性、人間による最終判断

- 必須サービスへのアクセス

- 公的支援、融資、保険等の判断

- 要件:包摂性、公平性、理由の説明

- 法執行

- 個人評価、嘘発見、証拠分析等

- 要件:精度保証、人権配慮、司法審査

- 移民・亡命・国境管理

- ビザ審査、国境管理、亡命申請評価

- 要件:国際法遵守、脆弱者保護、不服申立権

- 司法・民主的プロセス

- 法的調査、判決支援、選挙関連

- 要件:最高水準の信頼性、完全な透明性

ハイリスクAIの主要要件(第8-15条)

- リスク管理システム(第9条)

- 継続的・反復的なプロセス

- リスクの特定・分析・評価・軽減

- 残存リスクの受容可能性判断

- データガバナンス(第10条)

- 訓練・検証・試験データセットの品質管理

- 代表性、正確性、完全性の確保

- バイアスの検出と軽減

- 技術文書(第11条・Annex IV)

- 設計・開発・性能の包括的文書化

- 適合性評価に必要な全情報

- 継続的な更新義務

- 記録保持(第12条)

- 自動的なログ記録機能

- 最低6ヶ月の保存(法執行は1年)

- トレーサビリティの確保

- 透明性(第13条)

- 使用者への十分な情報提供

- 使用説明書の作成

- 解釈可能性の確保

- 人間の監督(第14条)

- 自然人による効果的な監督

- 停止・無効化機能

- 自動化バイアスの防止

- 精度・堅牢性・サイバーセキュリティ(第15条)

- 意図された目的に適した性能

- エラーや不整合への耐性

- 悪意ある攻撃への防御

3. 限定リスクAI(Limited Risk)- 第52条

限定リスクAIは、主に透明性の確保を求められます。利用者が「AIと対話している」「AIが生成したコンテンツである」ことを認識できるようにすることが主な要件です。

対象システムと要件

- 対話型AIシステム(チャットボット等)

- 要件:AIシステムであることの明示

- 例外:明白な場合、法的義務の履行

- 感情認識・生体分類システム

- 要件:システムの使用を対象者に通知

- 追加:データ保護規則の遵守

- ディープフェイク

- 要件:コンテンツが人工的に生成・操作されたことの開示

- 例外:法執行、表現の自由(パロディ等)

- テキスト生成AI

- 要件:AI生成であることの表示

- 特に:ニュース記事等の情報提供目的の場合

4. 最小リスクAI(Minimal Risk)

大部分のAIアプリケーションはこのカテゴリーに該当します。法的な義務はありませんが、自主的な行動規範の採用が推奨されています。

典型例

- スパムフィルター

- 在庫管理システム

- 推薦アルゴリズム(エンターテインメント)

- ゲームAI

- 翻訳ツール

3-3. 汎用AI(GPAI)モデルの特別規制

生成AIブームを受けて追加された汎用AIモデル規制は、EU AI法の特徴的な要素です。ChatGPT、Claude、Geminiなどの大規模言語モデルや、Stable Diffusion、DALL-Eなどの画像生成モデルが対象となります。

汎用AIモデルの定義と該当性

定義(第3条63項) 「大量のデータを使用して自己教師あり学習で訓練され、様々な用途に使用できる汎用性を持つAIモデル」

該当性の判断基準

- 汎用性:複数の異なるタスクに使用可能

- 規模:大規模なパラメータ数とデータセット

- 市場投入:EUで利用可能な状態

基本義務(全GPAIモデル)- 第52c条

- 技術文書の作成

- モデルアーキテクチャの詳細

- 訓練プロセスの説明

- 性能評価結果

- 計算資源の使用量

- EU著作権法の遵守

- 著作権者の権利尊重

- オプトアウト要求への対応

- Text and Data Mining例外の適切な適用

- 訓練データの概要公開

- データソースの説明

- データ処理方法

- 主要なデータカテゴリー

- 著作権で保護されたコンテンツの使用

- モデルカードの作成

- 意図された用途と制限事項

- 性能指標とベンチマーク結果

- 既知のリスクと軽減措置

システミックリスクモデルの追加義務 – 第52d条

該当基準

- 訓練に使用した計算量:10^25 FLOPs以上

- または欧州委員会による指定

追加要件

- モデル評価の実施

- 標準化されたプロトコルとツールの使用

- 敵対的テスト(レッドチーミング)

- 能力と限界の体系的評価

- システミックリスクの評価と軽減

- 大規模な社会的影響の分析

- 誤用・悪用のリスク評価

- 軽減措置の実施と文書化

- サイバーセキュリティ保護

- モデルとインフラの保護

- 物理的・サイバー攻撃への対策

- アクセス制御と監視

- エネルギー消費の報告

- 訓練時のエネルギー使用量

- 推論時の効率性

- 環境影響の評価

- 重大インシデントの報告

- EU AI Officeへの迅速な通知

- 影響範囲と対応措置の説明

- 再発防止策の実施

3-4. 実務でのリスク判定フローチャート

実際にAIシステムのリスクレベルを判定する際は、以下のフローに従います:

[スタート]

↓

[第5条の禁止事項に該当?]

├─ YES → [禁止AI:使用停止]

└─ NO

↓

[Annex IIの製品の安全コンポーネント?]

├─ YES → [ハイリスクAI]

└─ NO

↓

[Annex IIIの用途に該当?]

├─ YES → [ハイリスクAI]

└─ NO

↓

[人間との相互作用あり?]

├─ YES → [限定リスク:透明性義務]

└─ NO → [最小リスク:規制対象外]判定時の注意点

- 用途の特定が最重要: 同じ技術でも用途によってリスクレベルが変わります

- 複合的な使用: 複数の用途がある場合は、最も高いリスクレベルを適用

- 将来の用途変更: 用途を変更した場合は再評価が必要

- グレーゾーン: 判断に迷う場合は、より高いリスクレベルを想定して対応

4. 施行タイムライン完全版

4-1. 段階的施行の背景と意図

EU AI法の段階的施行は、企業に準備期間を与えつつ、最もリスクの高い分野から順次規制を開始する戦略的なアプローチです。この方式により、企業は計画的に対応を進めることができます。

4-2. 詳細な施行スケジュール

| 日付 | 適用開始項目 | 影響主体 | 具体的内容と対応事項 |

| 2024-08-01 | 法律発効 | すべての関係者 | ・官報掲載から20日後に発効 ・準備期間の開始 ・社内体制構築の開始時期 |

| 2025-02-02 | 禁止AI条項(第5条) | すべての提供者/利用者 | ・8つの禁止事項の完全適用 ・既存システムの即時停止義務 ・代替技術への移行完了期限 |

| 2025-05-02 | ガバナンス構造 | EU加盟国 | ・各国AI監督当局の設置 ・EU AI Officeの本格稼働 ・通報・相談窓口の開設 |

| 2025-08-02 | GPAI透明性義務 | 基盤モデル開発者 | ・技術文書の作成義務 ・著作権遵守体制の確立 ・訓練データ概要の公開 ・システミックリスク評価(該当モデル) |

| 2026-08-02 | ハイリスクAI要件・罰則全面適用 | 高リスク該当企業 | ・全113条の完全施行 ・適合性評価の義務化 ・CEマーキングの取得 ・制裁金規定の発効 |

| 2027-08-02 | 既存AIシステム | 既存システム運用者 | ・2025年8月以前のGPAIモデルの移行期限 ・技術文書の遡及的作成完了 ・完全準拠の最終期限 |

| 2030-08-02 | Annex III見直し | 欧州委員会 | ・ハイリスクリストの第1回定期見直し ・技術進歩を踏まえた改訂 ・新たなリスクカテゴリーの追加検討 |

| 2030-12-31 | 公的機関の移行期間終了 | 公的機関 | ・公的機関が使用する既存システムの移行完了 ・完全準拠義務の開始 |

4-3. 重要な経過措置と例外規定

既存システムの取り扱い

ハイリスクAIシステムの経過措置

- 原則: 2026年8月2日以前に市場投入されたシステムは、大幅な変更がない限り2030年まで継続使用可能

- 「大幅な変更」の定義:

- アルゴリズムの根本的な変更

- 用途の実質的な拡大

- リスクプロファイルに影響する機能追加

- 注意点: マイナーアップデートは「大幅な変更」に該当しないが、累積的な変更は該当する可能性

GPAIモデルの移行期間

- 2025年8月2日以前に市場投入されたモデル: 2027年8月まで猶予

- ただし、著作権関連の義務は即座に適用

- システミックリスクモデルへの該当性は継続的に評価

公的機関の特別措置

- 一般企業より長い移行期間(2030年12月31日まで)

- 国家安全保障関連システムは特別な例外規定

- 段階的な準拠計画の提出義務

セクター別の考慮事項

医療分野

- 医療機器規則(MDR)との調整期間

- 臨床試験中のAIシステムへの配慮

- 患者安全を最優先とした段階的移行

金融分野

- 既存の金融規制との整合性確保

- リスク評価手法の標準化期間

- 監督当局間の協力体制構築

教育分野

- 学年度を考慮した移行スケジュール

- 既存の評価システムの段階的更新

- 教職員のトレーニング期間確保

4-4. 企業が今すぐ始めるべき準備

施行日に向けて、以下の準備を時系列で進めることが重要です:

2025年2月まで(禁止AI対応)

- 全AIシステムの棚卸し実施

- 禁止AI該当性の緊急評価

- 該当システムの停止計画策定

- 代替ソリューションの検討開始

2025年8月まで(GPAI対応)

- GPAIモデル使用状況の把握

- 技術文書作成体制の構築

- 著作権コンプライアンス体制確立

- データ処理記録の整備

2026年8月まで(全面施行対応)

- ハイリスクAI要件への準拠

- 適合性評価の実施

- 継続的モニタリング体制構築

- インシデント対応体制確立

5. 学習のポイント & 優先順位

5-1. 効率的な学習のための3段階アプローチ

EU AI法の学習は、リスクの高さと緊急度に応じて優先順位をつけることが重要です。以下の3段階アプローチにより、限られた時間で最大の効果を得ることができます。

第1段階:リスク回避とクイックウィン(1-2週間)

目的: 即座に対応が必要な事項の把握と、早期に成果を出せる対策の実施

1. 禁止AI条項の完全理解

- 必読箇所: 第5条全文、Recital (23)-(36)

- 実施事項:

□ 第5条の8項目を一覧表作成□ 各項目の具体例を社内で共有□ 自社サービスとの照合チェックリスト作成□ 該当可能性のあるシステムの詳細調査 - 成果物: 禁止AI該当性評価レポート

2. ハイリスク判定の実施

- 必読箇所: 第6-7条、Annex III

- 実施事項:

□ Annex IIIの8カテゴリーを部門別に割り当て□ 各部門でのAI利用状況調査□ グレーゾーン案件のリスト化□ 優先対応順位の決定 - 成果物: ハイリスクAI判定マトリクス

3. クイックウィンの実現

- 限定リスクAIの透明性対応: チャットボットへの「AI表示」追加など、すぐに実施可能な対策

- 社内認知度向上: 経営層向け1ページサマリーの作成

- 予算確保: コンプライアンス対応の概算費用算出

第2段階:コンプライアンス体制構築(1-3ヶ月)

目的: 法的要件を満たすための体制と仕組みの構築

4. ハイリスクAI要件の体系的理解

- 必読箇所: 第8-15条(要件)、第16-29条(義務)

- 重点項目と実装方法:

| 要件 | 条文 | 実装のポイント | 必要なリソース |

| リスク管理システム | 第9条 | ・PDCAサイクルの確立 ・リスクレジスタの作成 ・定期レビュープロセス | ・リスク管理ツール ・専門人材1-2名 |

| データガバナンス | 第10条 | ・データ品質基準の策定 ・バイアス検出手法確立 ・データセット文書化 | ・データ品質ツール ・データサイエンティスト |

| 技術文書 | 第11条 | ・Annex IVテンプレート活用 ・version管理システム ・更新プロセス確立 | ・文書管理システム ・テクニカルライター |

| 記録保持 | 第12条 | ・ログ設計と実装 ・保存期間管理 ・アクセス制御 | ・ログ管理基盤 ・ストレージ容量 |

| 透明性確保 | 第13条 | ・利用者向け説明文書 ・UIでの情報提供 ・多言語対応 | ・UXデザイナー ・翻訳リソース |

| 人間の監督 | 第14条 | ・Human-in-the-loop設計 ・緊急停止機能 ・監督者トレーニング | ・システム改修 ・教育プログラム |

| 精度・堅牢性 | 第15条 | ・性能指標の定義 ・敵対的テスト ・セキュリティ監査 | ・MLOpsツール ・セキュリティ専門家 |

5. GPAI特則への体系的対応

- 必読箇所: 第52a-55条、Recital (152)-(160)

- 実施ステップ:

- モデルの棚卸しと分類(自社開発/他社利用)

- 計算量の把握(10^25 FLOPs基準での評価)

- 著作権処理フローの確立

- 技術文書テンプレートの準備

6. 組織体制の設計

- AI ガバナンス委員会の設置:

- 構成: 法務、技術、事業、リスク管理、情報セキュリティ

- 役割: 方針策定、リスク評価、インシデント対応

- 開催頻度: 月次定例 + 臨時対応

- 役割分担マトリクス (RACI):

| タスク | 経営層 | 法務 | 技術 | 品質 | 事業部 |

| リスク評価 | A | R | C | C | I |

| 技術文書作成 | A | C | R | C | I |

| 適合性評価 | A | C | I | R | I |

| 市場後監視 | I | I | C | R | C |

(R=実行責任、A=説明責任、C=協議、I=情報共有)

第3段階:継続的改善と高度化(3-6ヶ月)

目的: 持続可能な運用体制の確立と競争優位の創出

7. 運用プロセスの最適化

- KPIの設定と監視:

- コンプライアンス達成率

- インシデント対応時間

- 文書更新頻度

- 監査指摘事項数

- 自動化の推進:

- コンプライアンスチェックの自動化

- 文書生成の半自動化

- リスク評価のシステム化

8. 外部連携の強化

- 認証機関との関係構築

- 業界団体への参加(行動規範策定)

- 当局との建設的対話

9. 競争優位への転換

- 「AI倫理のリーダー」ポジショニング

- 信頼性による差別化

- 先行者利益の獲得

5-2. 部門別対応ガイド

各部門が具体的に何をすべきか、優先順位付けした行動計画を示します。

法務・コンプライアンス部門

即時対応(1ヶ月以内)

□ EU AI法対応チームの組成

□ 外部法律事務所の選定

□ 禁止AI条項の法的分析

□ 既存契約の影響評価

□ 制裁金リスクの定量評価短期対応(3ヶ月以内)

□ コンプライアンスプログラムの策定

□ 内部規程・ポリシーの制定

□ 契約テンプレートの更新

□ サプライヤー契約の見直し

□ 保険カバレッジの検討中期対応(6ヶ月以内)

□ 監査プログラムの確立

□ 当局対応手順の策定

□ グループ会社への展開

□ M&Aデューデリ項目への組み込み技術・開発部門

即時対応(1ヶ月以内)

□ AIシステムインベントリの作成

□ アーキテクチャ文書の整備

□ ログ設計の見直し

□ 開発プロセスへの組み込み検討短期対応(3ヶ月以内)

□ 技術文書作成プロセスの確立

□ MLOpsパイプラインの改修

□ バイアス検出ツールの導入

□ 説明可能性機能の実装

□ Human-in-the-loop機能の設計中期対応(6ヶ月以内)

□ AIガバナンスツールの導入

□ 自動コンプライアンスチェック

□ 継続的モニタリングシステム

□ インシデント対応自動化品質保証部門

即時対応(1ヶ月以内)

□ 既存QMSとのギャップ分析

□ AI特有のリスク項目追加

□ テスト戦略の見直し短期対応(3ヶ月以内)

□ AI品質管理プロセスの文書化

□ 適合性評価手順の策定

□ 性能指標の定義と測定方法確立

□ バリデーション手法の標準化中期対応(6ヶ月以内)

□ ISO/IEC 23053/23894準拠

□ 第三者認証準備

□ 継続的改善プロセス確立事業部門

即時対応(1ヶ月以内)

□ AI利用サービスの棚卸し

□ 顧客影響評価

□ 競合他社動向調査短期対応(3ヶ月以内)

□ サービス設計への要件反映

□ 顧客向け説明資料作成

□ 営業トークスクリプト更新

□ 料金体系への影響評価中期対応(6ヶ月以内)

□ 新サービス企画への組み込み

□ 差別化戦略の策定

□ マーケティングメッセージ開発

5-3. よくある質問と実務的回答

Q1: うちは小規模企業だが、全部対応する必要があるか?

A: EU AI法には中小企業への配慮規定があります(第56条)。以下の簡略化が可能です:

- 技術文書の簡略版使用

- 内部管理によるコンプライアンス(第三者認証不要な場合)

- 規制サンドボックスへの優先アクセス

- ただし、禁止AIとハイリスクAIの基本要件は企業規模に関わらず適用

Q2: 既に開発中のAIシステムはどうすればよいか?

A: 開発段階に応じた対応が必要です:

- 設計段階: 要件を設計に組み込む(手戻り最小)

- 開発中: 必須要件から順次実装、文書化を並行実施

- テスト段階: コンプライアンステストを追加

- リリース直前: 最低限の透明性要件を満たし、段階的に完全準拠

Q3: 米国のAI規制との違いは?

A: 主要な違いは以下の通りです:

| 観点 | EU AI法 | 米国アプローチ |

| 規制方式 | 包括的法規制 | セクター別・自主規制中心 |

| リスク分類 | 4段階の明確な分類 | ケースバイケース |

| 罰則 | 最大7%の制裁金 | セクター別に異なる |

| 適用範囲 | 域外適用あり | 原則国内のみ |

Q4: GDPR対応している企業の優位点は?

A: GDPR対応経験は大きなアドバンテージになります:

- ガバナンス体制が流用可能

- 文書管理プロセスが確立済み

- プライバシー影響評価のノウハウ活用

- 当局対応の経験

- ただし、AI特有の技術的要件は追加対応必要

Q5: 生成AIを使ったサービスの具体的な対応は?

A: 利用形態により対応が異なります:

- 他社APIを利用(GPT-4等)

- API提供者の準拠状況確認

- 利用規約での責任分担確認

- 出力への透明性表示実装

- ログ保存体制構築

- 自社でファインチューニング

- ベースモデルの情報入手

- 追加学習データの管理

- 用途に応じたリスク評価

- 技術文書への記載

- 自社開発モデル

- 計算量の把握(10^25 FLOPs基準)

- 完全な技術文書作成

- 著作権対応体制確立

- システミックリスク評価(該当の場合)

6. 実践的アドバイスとベストプラクティス

6-1. コンプライアンスを成功に導く10の原則

- 経営層のコミットメント確保

- CEOメッセージでの重要性発信

- 取締役会での定期報告

- 十分な予算とリソース配分

- アジャイルなアプローチ

- 完璧を求めず段階的改善

- 短いスプリントでの実装

- 定期的な振り返りと調整

- 文書化の習慣化

- 開発と同時進行での文書作成

- テンプレートの活用

- バージョン管理の徹底

- クロスファンクショナルな協働

- サイロを超えた情報共有

- 共通言語の確立

- 定期的な勉強会開催

- 外部リソースの戦略的活用

- 専門家の知見活用

- 業界団体での情報交換

- ツール・サービスの導入

- リスクベース思考の浸透

- すべてを同じ重要度で扱わない

- 影響度×発生確率での優先順位

- 残存リスクの明確化

- 透明性を競争優位に

- 積極的な情報開示

- 顧客への説明責任

- 信頼獲得による差別化

- 継続的な学習と改善

- 最新動向のキャッチアップ

- 失敗からの学習

- ベストプラクティスの蓄積

- グローバル視点での設計

- EU以外の規制動向も考慮

- 統一基準での運用

- 将来の規制強化への備え

- イノベーションとの両立

- 規制を制約でなく機会と捉える

- Responsible AIの実現

- 新たなビジネスモデルの創出

6-2. 落とし穴を避けるためのチェックリスト

よくある誤解と正しい理解

| よくある誤解 | 正しい理解 | 対策 |

| 「B2Bなら関係ない」 | エンドユーザーがEU市民なら適用 | バリューチェーン全体での確認 |

| 「技術的に不可能」 | 代替手段の検討義務あり | 早期の技術的実現可能性評価 |

| 「後から対応すればOK」 | 設計段階からの組み込みが必須 | Privacy by Designの応用 |

| 「文書は最後に作成」 | 同時進行が大前提 | アジャイル文書化プロセス |

| 「AIベンダーの責任」 | 利用者にも義務あり | 責任分担の明確化 |

| 「罰則は大企業だけ」 | 企業規模に関係なく適用 | 中小企業も基本対応必須 |

見落としがちな要件

- 市場後の継続的義務

- 定期的なリスク再評価

- 性能モニタリング

- インシデント報告

- 文書の更新

- サプライチェーン全体での対応

- 上流(AIモデル提供者)との連携

- 下流(最終利用者)への情報提供

- 中間事業者の役割明確化

- データ保護との交差点

- GDPRとの重複要件

- プライバシー影響評価との統合

- データ主体の権利への配慮

6-3. コスト最適化戦略

EU AI法対応には相応のコストがかかりますが、戦略的なアプローチで最適化が可能です。

コスト構造の理解

| コスト項目 | 初期投資 | 継続費用 | 削減方法 |

| 人件費 | 専門人材採用・教育 | 運用・監視要員 | 兼務体制、外部委託 |

| システム投資 | 改修・新規開発 | 保守・更新 | 既存システム活用、OSS利用 |

| 外部サービス | 法務・コンサル | 認証・監査 | 内製化、共同調達 |

| 文書作成 | 初期文書化 | 定期更新 | テンプレート化、自動化 |

| 認証費用 | 初回認証 | 更新認証 | 自己評価の活用 |

投資対効果を高める5つの戦略

- 共通プラットフォーム戦略

- 複数のAIシステムで共通利用

- スケールメリットの実現

- 管理コストの削減 例: 統一リスク管理システム、共通ログ基盤

- 段階的投資アプローチ

Phase 1: 必須要件のみ対応(禁止AI回避) Phase 2: 基本要件実装(最低限の準拠) Phase 3: 高度化・自動化(効率化) Phase 4: 差別化要素追加(競争優位) - 業界協調によるコスト分担

- 業界共通ガイドライン策定

- 認証スキームの共同開発

- ツール・テンプレートの共有

- 技術的ソリューションの活用

- AIガバナンスツールの導入

- 自動文書生成

- コンプライアンス自動チェック

- ビジネスモデルへの組み込み

- コンプライアンスコストの価格転嫁

- 信頼性による付加価値創出

- 新サービスの開発機会

6-4. 成功事例から学ぶベストプラクティス

事例1: 大手金融機関のアプローチ

- 課題: 与信判断AIがハイリスクに該当

- 対応:

- 既存のリスク管理フレームワークを拡張

- 説明可能AIの段階的導入

- 顧客向け透明性レポートの自動生成

- 成果: 規制準拠と顧客満足度向上の両立

事例2: EdTechスタートアップの工夫

- 課題: リソース制約下での対応

- 対応:

- OSSツールの活用

- 大学との共同研究で専門知識獲得

- 段階的な機能リリース

- 成果: 最小投資で基本要件クリア

事例3: 製造業でのAI品質管理統合

- 課題: 既存品質システムとの整合性

- 対応:

- ISO 9001とAI要件のマッピング

- 既存プロセスへのAI要件組み込み

- 従業員の追加トレーニング最小化

- 成果: 追加投資を抑えた準拠実現

7. まとめと次のステップ

7-1. EU AI法対応の本質

EU AI法への対応は、単なる規制準拠を超えて、組織のAI活用を次のレベルに引き上げる機会です。本法が求める透明性、説明責任、人間中心の設計は、結果的に以下をもたらします:

- 信頼されるAIの実現

- ユーザーからの信頼獲得

- ブランド価値の向上

- 持続可能なビジネスモデル

- 組織能力の向上

- AI活用の成熟度向上

- リスク管理能力の強化

- イノベーション力の向上

- 競争優位の確立

- 先行者利益の獲得

- 参入障壁の構築

- グローバル展開の基盤

7-2. 段階的アプローチの重要性

すべてを一度に実現しようとすると、組織は疲弊し、本来の目的を見失います。以下の段階的アプローチを推奨します:

第1四半期: 基礎固め

目標: リスクの把握と緊急対応

- AIシステムの棚卸し完了

- 禁止AI該当性の確認

- ハイリスク判定の実施

- 対応体制の構築第2四半期: 体制構築

目標: コンプライアンス基盤の確立

- 必要な規程・手順の策定

- 技術的対応の開始

- 文書化プロセスの確立

- 初期トレーニングの実施第3四半期: 実装と検証

目標: 要件の実装と有効性確認

- 技術的要件の実装

- 内部監査の実施

- ギャップ分析と改善

- 適合性評価の準備第4四半期: 最適化と定着

目標: 持続可能な運用体制

- プロセスの最適化

- 自動化の推進

- 継続的改善の仕組み

- 次年度計画の策定

7-3. 今すぐ着手すべき10のアクション

以下のアクションを優先順位順に実行することで、効率的な対応が可能です:

- 経営層へのブリーフィング(今週中)

- 1ページエグゼクティブサマリー作成

- リスクと機会の明確化

- 予算確保の根拠提示

- プロジェクトチームの組成(2週間以内)

- リーダーの任命

- 各部門からのメンバー選定

- 役割と責任の明確化

- AIシステムインベントリ作成(1ヶ月以内)

- 全社調査の実施

- 統一フォーマットでの記録

- リスクレベルの仮判定

- 禁止AI緊急チェック(1ヶ月以内)

- 第5条との照合

- 該当可能性の詳細評価

- 対応方針の決定

- 外部専門家の選定(1ヶ月以内)

- 法律事務所の選定

- 技術コンサルタントの評価

- 予算枠の設定

- ギャップ分析の実施(2ヶ月以内)

- 現状と要件の差分把握

- 優先対応事項の特定

- 対応計画の策定

- Quick Win施策の実行(2ヶ月以内)

- AI表示の追加

- 基本的な文書整備

- 社内周知活動

- ロードマップ策定(3ヶ月以内)

- マイルストーンの設定

- リソース配分計画

- リスク対応計画

- パイロットプロジェクト開始(3ヶ月以内)

- 代表的なAIシステムでの試行

- 課題の洗い出し

- 全社展開への教訓抽出

- 継続的改善プロセス確立(6ヶ月以内)

- KPIの設定と監視

- 定期レビューの実施

- 改善活動の推進

7-4. リソースとツール

必須ドキュメント

7-5. よくある追加質問

Q6: ChatGPTやClaudeのAPIを使うだけでも規制対象?

A: はい、使用方法によっては規制対象となります:

- 単純な社内業務効率化 → 最小リスク(規制対象外)

- 顧客向けチャットボット → 限定リスク(透明性義務)

- 採用選考での利用 → ハイリスク(厳格な要件)

- 感情分析での評価 → 状況により禁止AI

重要なのは「何を使うか」ではなく「どう使うか」です。

Q7: 違反が発覚した場合の実際の流れは?

A: 以下のプロセスが想定されます:

- 当局による調査開始(通報・職権)

- 情報提供要求への対応(期限付き)

- 是正措置の指示

- 改善計画の提出と実施

- 制裁金決定(改善されない場合)

- 不服申立て(該当する場合)

早期の自主的な是正と協力的な姿勢が、制裁金額に大きく影響します。

Q8: 他社のAIを組み込んだ製品の責任は?

A: 複雑ですが、基本的な考え方は:

- 提供者(最終製品の提供者)が主要な責任

- ただし、AIコンポーネント提供者にも一定の義務

- 契約での責任分担が重要

- エンドユーザーへの情報提供は必須

サプライチェーン全体での協力が不可欠です。

7-6. 最後に:成功への3つの鍵

EU AI法への対応を成功に導く3つの鍵を改めて強調します:

- トップダウンとボトムアップの融合

- 経営層の強いコミットメント

- 現場の創意工夫の促進

- 双方向のコミュニケーション

- 完璧主義より継続的改善

- 100点を目指さず60点からスタート

- PDCAサイクルの確立

- 失敗を恐れない文化

- 規制を機会に変える発想

- コンプライアンスを差別化要因に

- 新たなビジネスモデルの創出

- グローバルスタンダードへの貢献

EU AI法は確かに複雑で要求も厳しいですが、本質的には「人間中心のAI」を実現するための枠組みです。この理念に共感し、真摯に取り組む組織には、規制を超えた大きな価値がもたらされるでしょう。

まとめ

この記事が、EU AI法という広大な海を航海する皆様の羅針盤となることを願っています。規制対応は確かに大変ですが、それは同時に組織のAI活用を次のステージに引き上げる絶好の機会でもあります。

本記事で触れられなかった詳細や、実務での具体的な課題については、今後も継続的に情報発信していく予定です。皆様の実践から得られた知見やフィードバックも、ぜひお聞かせください。

共に、信頼されるAIの実現に向けて歩んでいきましょう。

免責事項: 本記事は一般的な情報提供を目的としており、法的助言を構成するものではありません。具体的な対応については、必ず専門家にご相談ください。

著作権: 本記事の内容は著作権で保護されています。引用の際は適切な出典表示をお願いします。商用利用をご希望の場合はお問い合わせください。